标题

一种基于多部证据取回增强的假新闻检测框架

作者和出处

Shenzhen University(深圳大学),Illinois Institute of Technology(伊利诺伊理工学院),Microsoft Research Asia(微软亚洲研究院).

摘要

在线传播虚假信息的便利性使得具有恶意意图的个人能够操纵公众舆论并破坏社会稳定。近年来,基于证据检索的假新闻检测方法越来越受欢迎,目的是可靠地识别假新闻并减少其影响。基于证据检索的方法可以通过计算证据与新闻中的主张之间的文本一致性来提高假新闻检测的可靠性。在本文中,我们提出了一种基于多步骤证据检索增强(MUSER)的假新闻检测框架,该框架模拟了人类在阅读新闻、摘要、查阅资料和推断新闻是否真实过程中的步骤。我们的模型可以显式地建立多份证据之间的依赖关系,并通过多步骤检索进行新闻验证所需的证据的多步骤关联。此外,我们的模型能够通过段落检索和关键证据选择自动收集现有证据,从而省去了手动收集证据的繁琐过程。我们在不同语言的真实世界数据集上进行了大量实验,结果表明,我们提出的模型在检测假新闻方面至少比最先进的基线方法在 F1-Macro 上高出 3%,在 F1-Micro 上高出 4%。此外,它还为最终用户提供了可解释的证据。

引言和结论

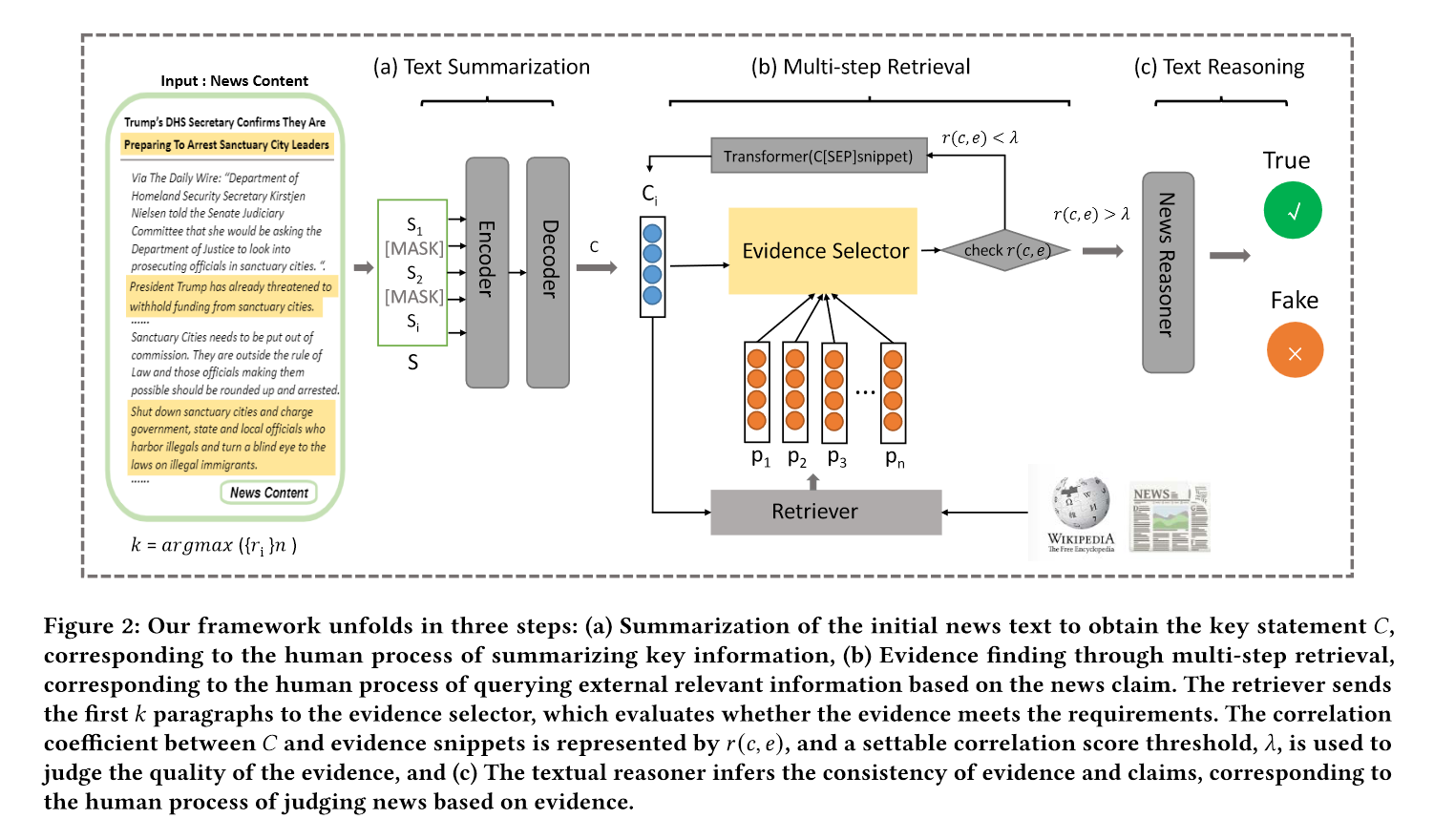

- 我们提出了一种基于多步骤证据检索的假新闻检测自动事实核查框架。我们的框架可以显式地建立多份证据之间的依赖关系,并通过多步骤检索获取新闻验证所需的证据。该框架模拟了人们在互联网上验证新闻内容时的搜索行为,使得计算机与人类专家在假新闻检测方面的差距变得更小。

- 我们提出的模型的实现包括三个核心模块:文本摘要、多步骤检索和文本推理。在多步骤检索模块中,我们采用关键证据选择的方法来控制跃点数量,实现自适应检索步长控制。

- 我们在三个真实世界数据集上开展了大量实验,结果表明,与最先进的模型相比,我们的模型在提高解释性和良好性能方面具有有效性。

方法

摘要模型

通过计算rogue分数挑选出最重要的m个句子并生成伪摘要。一开始新闻中有若干个句子,分别计算每个句子相较于其他句子的Rogue分数,挑选出最高分的句子加入集合并mask掉,重复若干次。 $$r_i=rouge(S\cup s_i,A\backslash{S\cup s_i}),\quad\forall i,\mathrm{~}s_i\notin S$$

证据取回模型

- 首先用文本摘要模型提取的关键信息去维基百科语料中进行搜索,找到相关段落。

$$r(c,p)=\varphi(c)^T\varphi(p)$$

$$\varphi(p)=\dfrac{1}{p}\sum_{i=1}^{|p|}BERT(p,i)$$ - 然后用取回的段落进行关键证据选择,挑选重要语句。有两种方法。

- 一种是计算相关度,大于阈值则挑选。For a given statement 𝐶, we select sentences 𝑠𝑖 from the retrieved relevant passages 𝑃 = {𝑠1, 𝑠2, . . . , 𝑠𝑛 } whose relevance score 𝑟 (𝑐, 𝑠𝑖 ) is greater than a certain threshold 𝜆 set experimentally.

- 另一种是上下文感知。使用BERT做序列标注任务,将Claim和Passage拼接送入BERT,重要语句第一个标注B,其他部分标注I,不重要语句标注O。最后计算交叉熵。

- 最后在挑选完证据以后,对挑选出来的证据进行评估。如果证据不够充分(即小于某个阈值),则进行多步证据取回,以补充证据。$C_{i+1}=Transformer([C_i[SEP]snippet])$查询每次挑选相关度最高的片段,并和上次的C向量组成新的查询向量,迭代查询。

文本推理模型

没什么好说的

个人感悟

前面两个模块感觉很有用,总体思路还是事实验证那一套,改进了证据取回的步骤,这样的多条推理更有说服力。